Chatbot basado en una versión ligera del modelo BERT para resolver inquietudes relacionadas con matrículas y homologaciones en la Universidad Nacional de Loja

DOI:

https://doi.org/10.54753/cedamaz.v12i2.1686Palabras clave:

Agente conversacional, inteligencia artificial, Chatbot, BERT, NLP, Metodología xpResumen

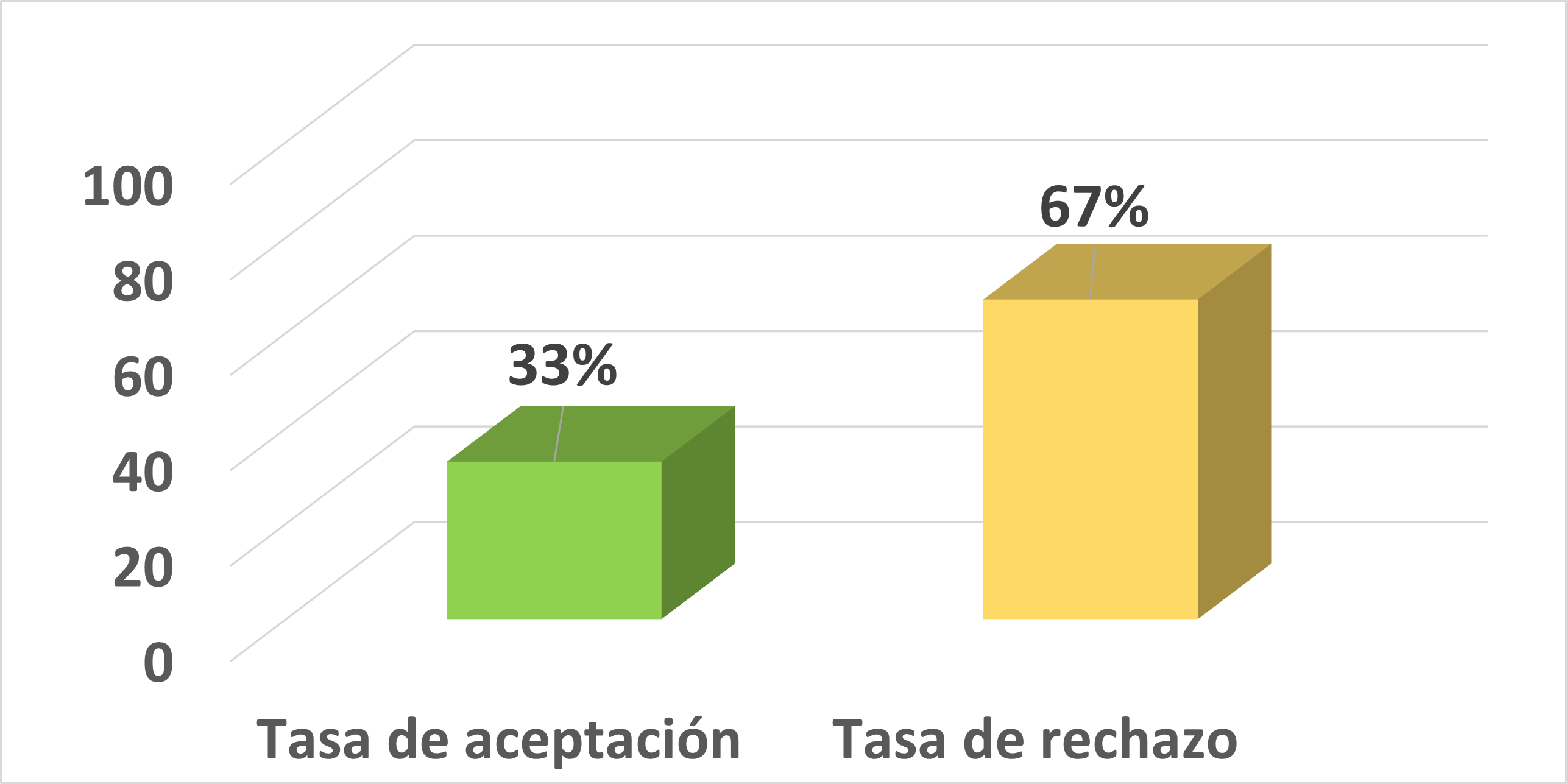

En este artículo se presenta el desarrollo de un chatbot utilizando como red neuronal una versión ligera del modelo BERT denominado DistilBERT, que ayude a estudiantes o profesionales a solventar inquietudes con respecto a matrículas y homologaciones para los estudios de cuarto nivel o posgrados en la Universidad Nacional de Loja (UNL). En este contexto, el proyecto se dividió en dos etapas: en la primera, se hizo una búsqueda bibliográfica en artículos científicos sobre las tecnologías y herramientas compatibles para realizar el ajuste del modelo BERT mediante un entrenamiento en la tarea de preguntas y respuestas; en la segunda etapa, se llevó a cabo el desarrollo del chatbot siguiendo la metodología de Programación Extrema (XP) dividida en cuatro fases: planeación, diseño, codificación y pruebas. En la fase de planeación, se llevó a cabo el entrenamiento del modelo, requisito necesario para la implementación del chatbot. En esta fase se especificaron los parámetros para el entrenamiento modelo y la descripción de forma general del funcionamiento del agente conversacional mediante historias de usuario. En la segunda fase se diseñó la arquitectura, en la que se muestran todos los elementos que formaron parte del chatbot. En la tercera fase se llevó a cabo la programación utilizando los lenguajes de programación Python, JavaScript, Css, Html y el microframework Flask. Finalmente, en la última fase se ejecutaron pruebas de rendimiento, carga y estrés para ver el comportamiento del chatbot al ser sometido a una carga considerable de peticiones.Citas

Al-Besher, A., Kumar, K., Sangeetha, M., y Butsa, T. (2022). BERT for Conversational Question Answering Systems Using Semantic Similarity Estimation. Computers, Ma-

terials and Continua, 70(3), 4763–4780. doi: 10.32604/cmc.2022.021033 DOI: https://doi.org/10.32604/cmc.2022.021033

Annamoradnejad, I., Fazli, M., y Habibi, J. (2020). Predicting Subjective Features from Questions on QA Web sites Using BERT. 2020 6th International Conference on Web Research, ICWR 2020, 240–244. doi: 10.1109/ ICWR49608.2020.9122318 DOI: https://doi.org/10.1109/ICWR49608.2020.9122318

Bagwe, R., y George, K. (2020). Automatic Numerical Question Answering on Table using BERT-GNN. 2020 11th IEEE Annual Ubiquitous Computing, Electronics and Mobile Communication Conference, UEMCON 2020, 118–124. doi: 10.1109/UEMCON51285.2020.9298028 DOI: https://doi.org/10.1109/UEMCON51285.2020.9298028

Bathija, R., Agarwal, P., Somanna, R., y Pallavi, G. (2020). Guided Interactive Learning through Chatbot using Bidirectional Encoder Representations from Transformers (BERT). 2nd International Conference on Innovative Mechanisms for Industry Applications, ICIMIA 2020 - Conference Proceedings(Icimia), 82–87. doi: 10 .1109/ ICIMIA48430.2020.9074905 DOI: https://doi.org/10.1109/ICIMIA48430.2020.9074905

Chan, Y., y Fan, Y. (2019). A Recurrent BERT-based Model for Question Generation. MRQA@EMNLP 2019 - Proceedings of the 2nd Workshop on Machine Reading for Ques-

tion Answering, 154–162. doi: 10.18653/v1/d19-5821 DOI: https://doi.org/10.18653/v1/D19-5821

Devlin, J., Chang, M.-W., Lee, K., y Toutanova, K. (2018). Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv. doi: 10.48550/ARXIV.1810.04805

He, Y., Zhu, Z., Zhang, Y., Chen, Q., y Caverlee, J. (2020). Infusing Disease Knowledge Into BERT for Health Question Answering, Medical Inference and Disease Name Recognition. EMNLP 2020 - 2020 Conference on Empirical Methods in Natural Language Processing, Proceedings of the Conference, 4604–4614. doi: 10.18653/v1/2020.emnlp-main.372 DOI: https://doi.org/10.18653/v1/2020.emnlp-main.372

Nikas, C., Fafalios, P., y Tzitzikas, Y. (2020). Two-stage Semantic Answer Type Prediction for Question Answering Using BERT and Class-specificity Rewarding. CEUR Workshop Proceedings, 2774, 19–28.

Publicado

Cómo citar

Número

Sección

Licencia

Derechos de autor 2022 CEDAMAZ

Esta obra está bajo una licencia internacional Creative Commons Atribución-NoComercial-SinDerivadas 4.0.

Aquellos autores/as que tengan publicaciones con esta revista, aceptan los términos siguientes:

-

Luego que el artículo científico es aceptado, para su publicación el o la autora aceptan ceder los derechos de la primera publicación a la Revista CEDAMAZ, conservando sus derechos de autor. Se permite la reproducción total o parcial de los textos que se publican siempre y cuando sea sin fines de lucro. Cuando se ejecute la reproducción total o parcial de los artículos científicos aceptados y publicados en la revista CEDAMAZ, se debe citar la fuente completa y la dirección electrónica de la publicación.

-

Los artículos científicos aceptados y publicados en la revista CEDAMAZ pueden ser depositados por los autores de manera integra en cualquier repositorio sin fines comerciales.

-

Los autores no deben distribuir los artículos científicos aceptados, pero que todavía no han sido publicados oficialmente por la revista CEDAMAZ. En el caso de incumplir esta norma implica el rechazo del articulo científico.

- La publicación de su obra, el cuál estará simultáneamente sujeto a la Licencia de reconocimiento de Creative Commons